K8s 容器运行时之争:从 Docker 到 Containerd 迁移过程中你会遇到哪些坑

随着Kubernetes社区正式移除了对内置的dockershim的支持,将K8s集群的容器运行时(CRI)从Docker切换到原生Containerd已成为主流趋势。虽然Containerd是Docker的核心组件,但这种切换并非无缝。本...

随着Kubernetes社区正式移除了对内置的dockershim的支持,将K8s集群的容器运行时(CRI)从Docker切换到原生Containerd已成为主流趋势。虽然Containerd是Docker的核心组件,但这种切换并非无缝。本...

Docker 作为容器技术的基石,解决了应用打包和环境隔离的难题。然而,当应用进入生产环境,对稳定性、伸缩性和可管理性提出要求时,仅靠 Docker CLI 或 Docker Compose 就显得力不从心。这就是为什么 Docker 之后...

对于运行在公有云VPS或Docker容器中的Celery Worker,正确选择并发池(Pool)是提高任务吞吐量和资源利用率的关键。在Ubuntu Docker环境中,我们通常需要在内存效率和CPU利用率之间做出平衡。 1. Celery...

在使用 VPS 或公有云虚拟机搭建服务时,Docker 和 Docker Compose 是常用的部署工具。然而,如果不注意清理,Docker 留下的持久化卷(Volume)会迅速占用大量的磁盘空间,尤其是数据库或日志相关的卷。本文将详细指...

在AI基础设施的运维中,数据存储层的稳定性和可迁移性至关重要。MinIO作为高性能的对象存储解决方案,常用于存储训练数据集、模型权重和推理日志。当需要进行硬件升级、集群扩容或主机维护时,我们必须将运行在Docker中的MinIO实例及其所有...

在AI基础设施部署中,Kubernetes是核心调度层,而RKE(Rancher Kubernetes Engine)是快速部署K8s集群的强大工具。然而,RKE对底层依赖,尤其是Docker运行时版本,有着严格的限制。当遇到 Unsupp...

vLLM因其出色的GPU吞吐量而闻名,但在某些场景下(如本地开发、功能测试或资源受限的环境),用户可能需要在纯CPU上运行vLLM服务。虽然性能远不如GPU,但通过正确的配置,我们依然可以利用vLLM的简洁API和高效加载机制在CPU上启动...

在使用Docker部署AI模型或进行深度学习训练时,我们经常需要利用NVIDIA GPU进行加速。然而,尝试运行带有–runtime=nvidia或现代–gpus all参数的容器时,可能会遇到以下错误: docke...

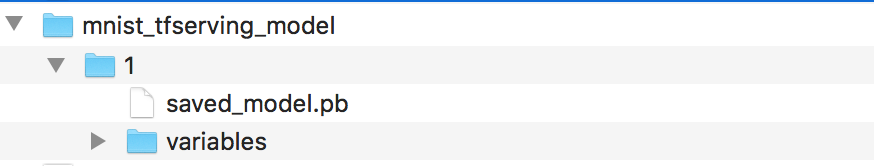

java通过gRPC整合tensorflow serving(之二)——安装tfserving并部署示例模型 承接上一篇【java通过gRPC整合tensorflow serving——gRPC java入门例子】 这是本系列的第二篇,上一...

CentOS解决Docker Networking Disabled: WARNING: IPv4 forwarding is disabled. Networking will not work 由于我的tensorflow servin...